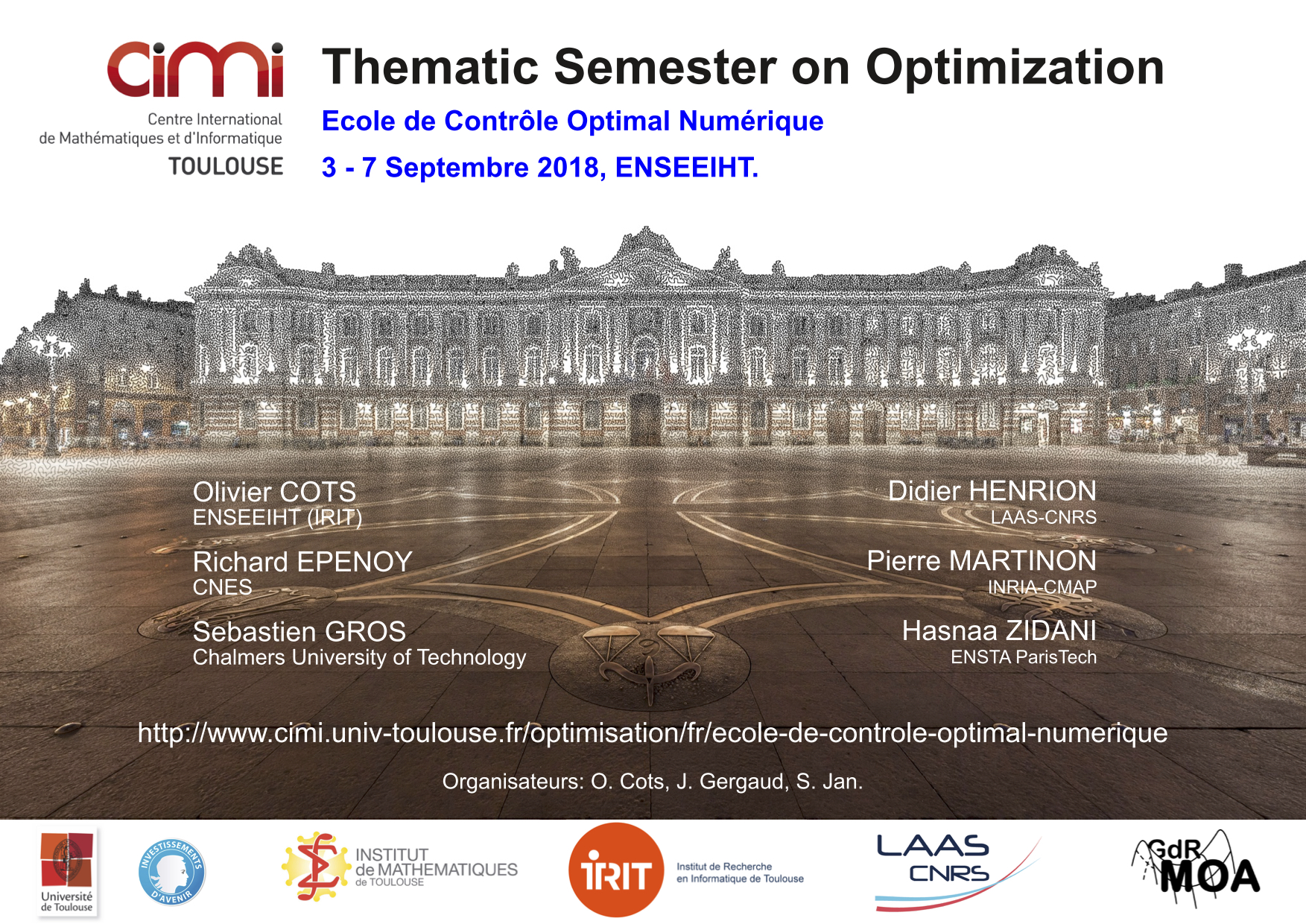

École de Contrôle Optimal Numérique

École de Contrôle Optimal Numérique

Evénement CIMI, Toulouse, FRANCE

3-7 septembre 2018

Le contrôle optimal dans les équations différentielles ordinaires intervient dans maintes applications, en particulier dans le domaine spatial. Les avancées scientifiques dans ce domaine ces dernières années ont été importantes : contrôle géométrique, optimisation de grande taille, intégration géométrique, différentiation automatique, méthodes de relaxations semi-définies pour la commande optimale; et des codes performants ont été développés (Bocop, HamPath, GloptiPoly, Acado, WORHP). C'est pourquoi, il nous paraît important de faire le point sur les méthodes de résolution numérique de ces problèmes.

Cette école de niveau doctoral est ouverte aux doctorants, post-doctorants, ainsi qu'aux industriels (CNES, THALES, ...) et chercheurs du domaine concerné. Les cours et séances pratiques seront dispensées en français.

Sous réserve de l'acceptation par votre école doctorale, cette semaine pourrait vous permettre d'obtenir quelques crédits pour votre formation doctorale.

Inscriptions

Les inscriptions sont désormais closes.

Orateurs confirmés

- Olivier Cots (IRIT)

- Richard Epenoy (CNES)

- Sébastien Gros (Chalmers University of Technology)

- Didier Henrion (LAAS-CNRS)

- Pierre Martinon (INRIA-CMAP)

- Hasnaa Zidani (ENSTA ParisTech)

Programme

Vous trouverez le programme ici : ![]() programme-cimi-con.pdf

programme-cimi-con.pdf

Codes

- Bocop : http://www.bocop.org

- Casadi : https://web.casadi.org

- GloptiPoly : http://homepages.laas.fr/henrion/software/gloptipoly/

- HamPath : http://www.hampath.org

Résumés

- Olivier Cots et Richard Epenoy (méthodes indirectes) :

Un problème de contrôle optimal (PCO) est un problème d’optimisation en dimension infinie présentant des contraintes algébriques et différentielles. Un exemple simple de problème PCO sous forme de Lagrange est le suivant. Trouver une loi de commande permettant de déplacer un système dynamique contrôlé d’une configuration initiale vers un état cible tout en minimisant une fonction objective représentant le coût de la trajectoire suivie par le système. Nous présenterons en cours le Principe du Maximum de Pontryagin (PMP) qui fournit un ensemble de conditions nécessaires d’optimalité. D’un point de vue numérique, l’application du PMP mène à la construction d’un problème aux deux bouts qui est ensuite résolu par des méthodes de tir (simple ou multiple) ou de collocation. En TP, ces méthodes dites indirectes seront étudiées sur une sélection d’exemples et les expérimentations numériques seront réalisées avec l'outil HamPath (http://hampath.org).

- Richard Epenoy (un exemple d’application industrielle en spatial) :

Nous verrons à travers deux applications récentes du contrôle optimal en mécanique spatiale quelles difficultés numériques sont rencontrées lors de l’application des méthodes indirectes et comment traiter ces difficultés. La première application concerne le calcul de trajectoires à énergie minimum entre orbites périodiques (Libration Point Orbits) du problème circulaire restreint à trois corps Terre-Lune. Nous verrons en particulier que les transferts entre orbites de même énergie conduisent à un phénomène de « turnpike ». La seconde application traitera du transfert Terre-Lune à poussée électrique dans le problème bicirculaire restreint à quatre corps Terre-Lune-Soleil. Nous verrons comment traiter ce problème de contrôle à la dynamique très instable afin de générer des trajectoires localement optimales et les interpréter du point de vue de la mécanique céleste. Nous verrons en particulier que les trajectoires à plus faible coût exploitent les variétés stables et instables des deux sous problèmes à trois corps Terre-Lune et Soleil-Terre.

- Sébastien Gros (Méthodes directes)

Les méthodes directes sont, en pratiques, les plus répandues pour le traitement de problèmes de contrôle optimal soumis à des équations différentielles ordinaires et équations différentielles-algébriques. Les méthodes directes constituent une famille de méthodes (tir simple, tir multiples, collocation) avec des propriétés (convergence, bassin d’attraction, structure des condition de KKT) différentes. Dans ce cours nous allons étudier ces différentes méthodes et leur propriétés, identifier quel cas appel quelle méthode, et finalement étudier la connection qui relie tir multiple et collocation.

- Didier Henrion (LMI) : The Lasserre hierarchy for polynomial optimal control

Polynomial optimal control consists of minimizing a polynomial Lagrangian over a polynomial vector field subject to semi-algebraic control and state constraints, a typically nonconvex problem for which there is no solution in classical Lebesgue spaces. To overcome this, polynomial optimal control problems are first formulated as linear programming (LP) problems in the cone of occupation measures (standard objects in Markov decision processes and ergodic theory of dynamical systems), and infinite-dimensional convex duality is used to establish the link with subsolutions of the Hamilton-Jacobi-Bellman partial differential equation satisfied by the value function. Then, the Lasserre hierarchy of linear matrix inequality (LMI) relaxations is applied to solve numerically with semidefinite programming these infinite-dimensional LP problems.

- Pierre Martinon (Méthodes directes) :

Ce cours présente la classe de méthodes en contrôle optimal dites 'directes'. Ces approches sont basées sur une discrétisation temporelle qui permet de reformuler un problème de contrôle optimal en un problème d'optimisation non linéaire. Ce nouveau problème, de dimension finie, peut alors être résolu par des algorithmes de type SQP ou point intérieur. Le cours introduira les grands principes de ces méthodes directes, ainsi que leurs principaux avantages et inconvénients. Le TP illustre l'application des méthodes directes sur des problèmes de contrôle optimal. Les expérimentations numériques seront réalisées avec l'outil Bocop (http://bocop.org) sur une sélection d'exemples.

- Hasnaa Zidani (Méthodes HJB) :

Une approche importante en commande optimale est celle dite de Hamilton-Jacobi-Bellman (HJB). Elle permet d’identifier la fonction valeur, qui décrit la dépendance du coût minimum par rapport aux conditions initiales, comme la solution d'une équation aux dérivées partielles (EDP) de type Hamilton-Jacobi-Bellman. La résolution de cette EDP donne à la fois le coût minimum et le contrôle optimal dans une forme feedback adaptée à de nombreuses applications en ingénierie. L'approche HJB est particulièrement intéressante pour la planification des systèmes et permet d’obtenir les solutions optimales globales même lorsque le problème n’est pas convexe. Ce cours présentera quelques élèments théoriques et numériques pour la mise en œuvre effective de cette approche.

Comité d'organisation

- Olivier Cots (IRIT)

- Joseph Gergaud (IRIT)

- Sophie Jan (IMT)

Comité scientifique

- Olivier Cots (IRIT)

- Richard Epenoy (CNES)

- Joseph Gergaud (IRIT)

- Didier Henrion (LAAS)

- Pierre Martinon (equipe COMMANDS, INRIA et CMAP)

Informations pratiques

L'école se déroulera à l'ENSEEIHT, en centre ville de Toulouse. Pour plus de précisions, merci de suivre ce lien.

Contact

Pour toute question, merci de nous contacter.